AIの民主化が進行するにつれて、そのスーパーパワーが悪用されるリスクもかつてないほど高まっている。今年初めにニューヨーク・タイムズによって報じられた顔認識サービス「Clearview AI」の事例から、SNSやWeb上の公開画像を利用して一般市民の顔認識モデルが作成できてしまうことが明るみに出た。

こうしたAI顔認識の脅威からプライバシーを守るための取り組みとして、シカゴ大学のSAND Labは顔認識モデルを無効にするためのツール「Fawkes」を公開している。

最先端の顔認識モデルも騙せる

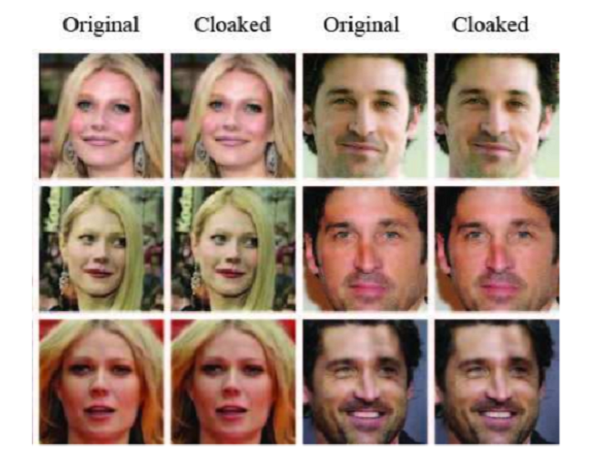

AI画像認識には「アドバーサリアル・エグザンプル」として知られる脆弱性があり、画像をピクセルレベルで微調整することによりAIを欺くことができる。Fawkesでは、写真に人間が見てもわからないような特殊なノイズを紛れ込ませることができる。

これまでにも、着用すると顔認識ができなくなるTシャツや帽子などはあったが、Fawkesがこれらと大きく違うのは、特定のものを着用する必要がないこと、そして広範な顔認識モデルで通用することだ。

テストでは、Fawkesが最先端の顔認識モデル、Microsoft Azure FaceAPIやAmazon Rekognition、Face++に対して100%効果を発揮したとのこと。

一般ユーザーが簡単に利用できる

また、こうしたツールは専門的な知識をもったユーザーのみが利用するのが常だったが、Fawkesは一般ユーザーの利用を想定している。

Fawkesの発想としては、トレーニングデータに誤った画像を紛れ込ませてしまうこと。普段のSNS投稿にFawkesで処理した画像をアップロードしておくという使い方だ。

すでにWeb上にある画像がトレーニングに用いられていたとしても、新たに追加する画像の割合が高くなっていけば効果を発揮するとのこと。

Fawkesは公式ページからダウンロードできて、Mac版、Windows版、Linux版が利用可能となっている。

参照元:Image “Cloaking” for Personal Privacy /SAND Lab

- Original:https://techable.jp/archives/133736

- Source:Techable(テッカブル) -海外・国内のネットベンチャー系ニュースサイト

- Author:YamadaYoji

Amazonベストセラー

Now loading...