モーションキャプチャといえば、マーカー付きスーツを着用して、身体の各部位の位置をトラッキングする姿を想像しがちだ。

ARやCG制作などで用いられる同技術。実は行動科学など研究領域でも使用される。動物の動きを分析するのに、マーカー付きのスーツの利用はむつかしい。この課題を解決するため、スイス連邦工科大学ローザンヌ校(EPFL)の研究者らは、モーションキャプチャとディープラーニングの組み合わせた。

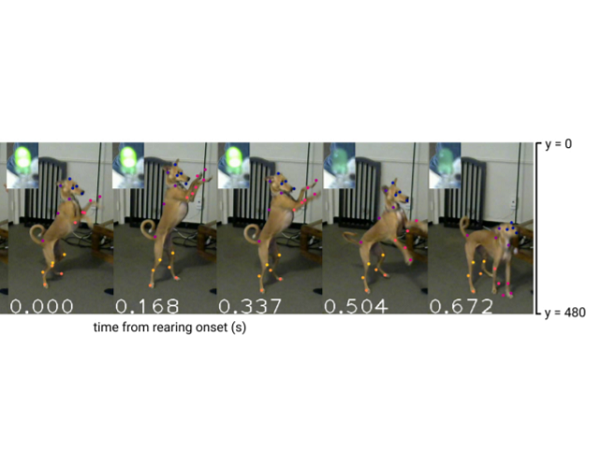

ディープラーニングツール「DeepLabCut-Live!」は、ビデオフレームに基づいて動物の動きをトラッキングできる。

動物の姿勢推定を神経メカニズムの研究に

DeepLabCut-Live!は、マーカーなしに動物の動きや姿勢をトラッキングし、これを予測するように訓練できる。

DeepLabCutはもともと、動物が環境の変化に応じて姿勢を適応させる方法を分析するために開発されたもの。動物が環境の急速な変化にどのように適応するか、神経回路が行動をどのように制御するかの研究に役立つ。

例えば、私たちはマグカップでコーヒーを飲むときに、特に意識せず重量の変化に応じて握力や腕の持ち上げ具合を調整している。この動き1つとっても、実際には皮質から脊髄に至るまでの大量の神経回路が関与しているとのこと。

リアルタイムでの分析を可能に

行動の神経メカニズムを研究するうえでは、分析のリアルタイム性が非常に重要になる。最新のDeepLabCut-Live!では、標準GPUで最大2500FPSとハイスループット分析が可能。待ち時間が短いため、動物にリアルタイムでフィードバックを提供し、特定の神経回路の行動機能をテストできる。

モジュール式なので、BonsaiやAutopilotなど、研究で使用されるさまざまなハードウェアやインターフェースで利用できるとのこと。

DeepLabCut-Live!は最近オープンソースとして公開され、プロジェクトのWebサイトでは活用事例を確認することなんかも可能だ。

参照元:DeepLabCut-Live! real-time marker-less motion capture for animals/ EPFL News

- Original:https://techable.jp/archives/144996

- Source:Techable(テッカブル) -海外・国内のネットベンチャー系ニュースサイト

- Author:YamadaYoji

Amazonベストセラー

Now loading...