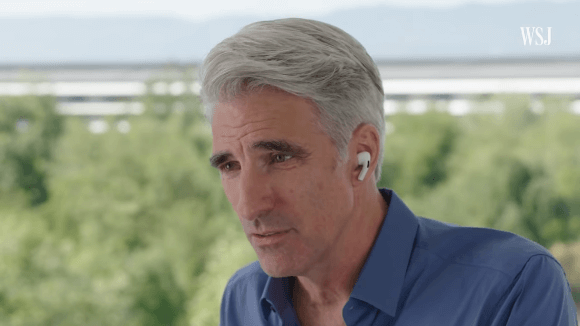

Appleのソフトウェアエンジニアリング担当上級副社長クレイグ・フェデリギ氏は、The Wall Street Journalのインタビューに答え、iCloudとiMessageの2つのサービスで実施される児童虐待の防止方策について、「大きく誤解されている」と述べました。

2つの機能を同時に発表したのが誤解の原因?

Appleは先日、iCloudに保存される写真とiMessageの両方で導入される新たな児童虐待の防止方策を発表しました。フェデリギ氏は、新しいCSAM(児童性的虐待のコンテンツ)検知システムと、性的な写真を検知する新しいコミュニケーションの安全性機能を同時に発表したことにより、「このような誤解を招くことになった」とコメントしています。

「(伝えたかった)多くのメッセージがひどくごちゃ混ぜになってしまった」

クラウドストレージのスキャンはみな行っている

フェデリギ氏によれば、Appleがユーザーの写真をスキャンしているというのは、「ただ間違いである」とのことです。「AppleはiPhoneの中の児童性的虐待写真を探しているわけではない。(中略)当社がやっているのはiCloudに保存された違法画像を見つけ出すことだ」

他のクラウドサービスもCSAMの検知を行っていますが、フェデリギ氏いわく、Appleの手法では写真を見ることなく振り分けができるとのことです。

同氏によると、“マルチパートアルゴリズム”を使用し、一定の解析をオンデバイスで行い、ある程度の分析をクラウド上で行って児童ポルノ写真を検知しているそうです。

30枚の違法画像が検知されるまで、Appleはアカウント情報や問題の写真について知らされることはないといいます。ちなみに、もし仮にアカウントが境界線を超えたとしても、違法画像以外の写真を確認したりすることはないとのことです。

フェデリギ氏はバックドアではないと主張

電子フロンティア財団(EFF)は、Appleの新CSAM検知システムに関して「バックドアの設置にほかならない」と批判しましたが、フェデリギ氏は「バックドアではない」と真っ向から否定しています。

また、同時に発表されたコミュニケーションの安全性機能は、機械学習を使って、子どもが送受信する性的コンテンツを検知するというもので、「100%、CSAMの検知とは異なる」と同氏は述べています。

Source:iMore

(lexi)

- Original:https://iphone-mania.jp/news-390201/

- Source:iPhone Mania

- Author:iPhone Mania

Amazonベストセラー

Now loading...