© 2021 UNLABELED

同アイテムは、株式会社Qosmoが慶應義塾大学SFC、Dentsu Lab Tokyoと共同で立ち上げた「UNLABELED」プロジェクトによるもの。AI領域でメディアアートや制作ツールを手がける同社は、その技術を応用してAIを“ハックする”カモフラージュ柄を生み出したのです。

今回は、カモフラージュ柄生成システムの開発に携わったエンジニアの中嶋亮介さんにお話を伺いました。

なぜ、AI企業がAIをだますカモフラージュ柄を開発したのでしょうかーー。

その背景には、AI監視カメラの社会実装に伴う「ラベリング」への危惧がありました。

AIで社会生活を豊かにすることを目指すQosmo

ーーまずは御社の事業内容を教えてください。

中嶋:Qosmoは、アートとAIテクノロジーを通じて人類の創造性を拡張することを目指して、作品やツールを制作しています。

普段から得意としているのは、「AIと音楽」の組み合わせです。人間のDJとAIが交互にプレイすることによって思いもよらない選曲を編み出そうという企画や、AIによる音楽自動生成プログラムを使用したパフォーマンスなどを発表しています。

ほかには、USENと共同でAIを用いた店舗向けBGM選曲システムの構築にも取り組んでいます。季節や時間、天候に合わせてその場に合うBGMを選出するシステムです。

「UNLABELED」もそうですが、さまざまな取り組みを通じてAIで人々の社会生活をより豊かにすることを目指しています。

ーーAIを駆使したプロジェクトのひとつが「UNLABELED」とのことですが、着るだけでAI監視カメラをだますことができるんですよね?

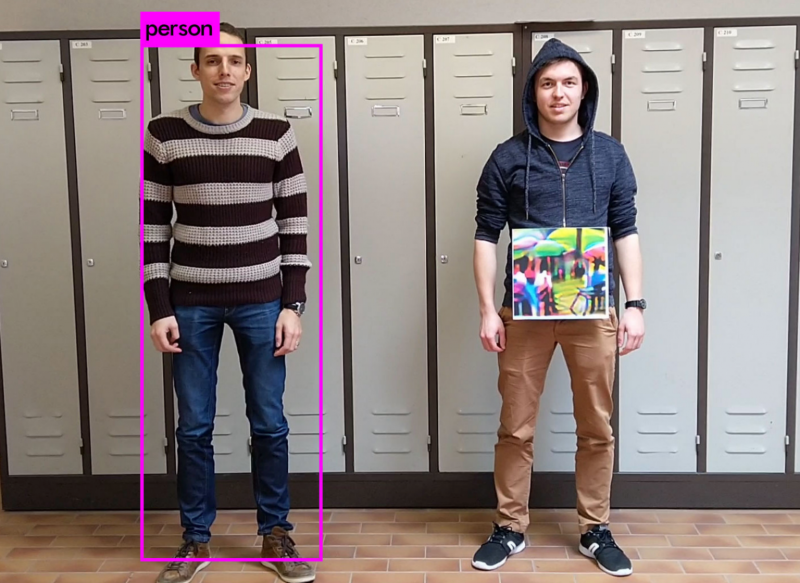

中嶋:はい。特定の柄を見せるとAIカメラが誤認識することがわかっているので、その技術を活用して対AI監視カメラのカモフラージュ柄を作りました。

この柄が入ったアイテムを身につければ、AI監視カメラから「人」として認識されにくくなります。

AI企業が警鐘するAI監視カメラの危険性

ーー技術的な部分は後ほど詳しく伺いたいのですが、その前にこのプロジェクトを御社が手がける理由をお聞かせください。

ーー技術的な部分は後ほど詳しく伺いたいのですが、その前にこのプロジェクトを御社が手がける理由をお聞かせください。

中嶋:このプロジェクトの主たる目的は、「AI監視カメラ」の危険性を世の中に提示することです。

慶應義塾大学SFCさん、Dentsu Lab Tokyoさんとコラボレーションをする際に議論になったのが、AI監視カメラのようなAIを組み込んだシステムによるラベリングの是非についてでした。

弊社のミッションは「人類の創造性の拡張」ですが、AI監視カメラによるラベリングはその可能性を狭める危険性があります。だから、逆にAIの目を欺く技術を開発してみました。

ーー具体的にはどのような危険性があるのでしょうか?

中嶋:現在の技術では、カメラに映った対象者の性別や年齢、人種などを推定できます。これを「ラベリング」と呼びます。

便利な技術である一方で、カメラに映っただけで知らず知らずのうちに勝手にラベリングされる恐れがありますし、外面だけで判断してラベリングされることはある種の人権侵害です。

中国などでは国家主導でAIカメラによる監視が行われていて、プライバシーの侵害ではないかという議論も起こっています。いわゆる「AI倫理」の問題ですね。

AI監視カメラは存在自体に倫理的な問題がありますが、「ラベリング」は公共のシステムにも組み込まれる可能性があります。「体温が高いと建物にアクセスできない」などのように、人種や年齢を理由に制限をかけることも技術的には可能です。

ここで問題なのは、体温以外の人種や年齢などを理由にしたアクセス拒否は不当な差別だということです。

そこで、AI監視カメラの危険性を議論するきっかけを作るためにUNLABELEDを企画して、カメラの目を欺いてみようと思いました。

AIは「神様」ではない

ーーなるほど。AI監視カメラは便利な反面、倫理的な課題があるということですね。

中嶋:さらに危険性を補足すると、AIは万能ではありません。

たとえば人種の推定をする際には、さまざまな肌の色の人間のデータセットを用意してアルゴリズムを作ります。そもそもデータセットに偏りがあった場合、十分な推定をすることができません。

「AI」という言葉を使うと客観的だと錯覚しそうになりますが、決してそうではありません。人間が作ったシステムなので悪意がなくともミスが起こりえます。

当然、悪意があれば不平等なシステムが生まれますが、私たちが身の回りにあるAIの判定基準を知る方法はほとんどありません。そのAIを開発した企業でないとアルゴリズムにアクセスすることができないからです。

身近な例ですと、新卒採用の場で「エントリーフォームに入力した大学名でフィルターをかけられていた」というスキャンダルがネット上でたびたび話題になりますよね。しかし、すべてのフィルタリングやラベリングが社会に表出しているとは限りません。

①知らず知らずのうちに、②勝手に人種や年齢など個人のプライバシーに関わる情報を推定され、③しかもその推定が誤りである可能性がある。

これが、AI監視カメラによる「ラベリング」の危険性です。

ーーAI領域で活躍する御社が対AI監視カメラのカモフラージュに取り組む意図がよくわかりました。

中嶋:AI監視カメラと全面戦争をしたいわけではないのですが、「人類の創造性を拡げる」ために、前提を疑い既存のシステムをハックして問いを立てることがUNLABELEDの目的です。

ーー「AI企業がAIの脆弱性を追求する」ということで、同業の方たちの反応はありましたか?

中嶋:怒られるかもと心配していましたが、案外面白がってくれています。

先日UNLABELEDの展示会を行った際に、多くの関係者さんがいらっしゃったのですが、実際にAI監視カメラを開発している方からも「脆弱性の指摘はアルゴリズムを作る側にとってもありがたい」「改善点として受け止めたい」という温かい声をいただきました。

より良い社会を作りたいという目標は同じなので、少なくとも弊社側から敵対意識があるわけではないです。

「人」として認識されにくくするための仕組み

参照:https://arxiv.org/abs/1904.08653

中嶋:Adversarial Patchというアルゴリズムを応用しています。

まず、データセットとして街の中で人が写っている画像を用意し、人の上にグレーの画像を貼りつけます。これくらいだとAIを騙すことはできませんから、誤認識を引き起こすように画像の色を少しづつ変えていきます。たとえば10ピクセル×10ピクセルの画像があったとすると、100ピクセルそれぞれのRGB値を計算で微調整していきます。

検証した結果、カラフルでサイケデリックに見える今のUNLABELEDの柄が、「YOLOv2」という物体検出モデルの目を最も欺きやすいことがわかりました。

この柄を着用していれば、特別な技術や知識がなくても、AI監視カメラに「人」として認識されにくくなるという仕組みです。

ーー今後に向けて技術的な課題はありますか?

中嶋:ひとつはいたちごっこであること。現在、弊社はYOLOv2に対するカモフラージュを制作していますが、YOLOv5などのアップデート版はさらに精度が高くなっています。

もうひとつは「衣服は立体的なオブジェクトである」ということ。最新のラインナップはプリントTシャツですが、カモフラージュ柄を全面に施したコートなど立体的な服の開発も行ったことがあります。しかし、やはり技術的には課題が多いです。

今回のようなTシャツであっても、衣服にはシワやたわみが発生するので、それを加味してカモフラージュできるかは技術者の腕の見せどころになります。

ーー今後の展開は?

中嶋:もともと、「カモフラージュ柄」は戦地で敵の目から逃れるためのモノでしたが、今ではファッションアイテムとして広く受け入れられていますよね。同じように私たちの生み出したカモフラージュ柄も、技術やAI倫理に関心を持っていなかった方に面白がってもらえるように浸透させたいです。

そのためには、「カメラに柄をかざしてみてください!」という技術デモをするよりも、格好良いファッションアイテムとして身につけてもらうことが近道なのかなと思います。

また、今回のUNLABELEDでは単にAIをだましやすい柄を追求していますが、特定の柄を用意し、その柄の良さを残しつつカモフラージュ効果を発揮することも可能です。たとえば、浮世絵をベースに画像を生成して、浮世絵のタッチを残したままカモフラージュ機能もある絵柄なども作れます。

あくまでAIをだますことが前提ですので、そのために絵柄を調整します。結果としてユニークなデザインに仕上がるはずです。

技術的な面はもちろんですが、ファッションとして格好良いプロダクトを世に出すことで、弊社の抱える問題意識を多くの方と共有できればと思います。

(文・川合裕之)

- Original:https://techable.jp/archives/171463

- Source:Techable(テッカブル) -海外・国内のネットベンチャー系ニュースサイト

- Author:amano

Amazonベストセラー

Now loading...