Appleは今年後半にiPhone、iPad、Macで導入予定の、新しいアクセシビリティ機能のプレビューを紹介しています。

iOS17、iPadOS17、macOS14で新アクセシビリティ機能が導入

Appleによると、認知、スピーチ、音声、視覚をサポートするアクセシビリティの新機能は「今年後半」に登場するとのことなので、iOS17、iPadOS17、macOS14で追加されるとみていいでしょう。これらの次期OSは、現地時間6月5日開幕の世界開発者会議(WWDC23)で発表され、秋にリリースされる見通しです。

Appleが紹介している新たなアクセシビリティ機能は以下のとおりです。

アシスティブアクセス

「アシスティブアクセス」は、iPhoneおよびiPadアプリの主な機能を抜き出して、簡単に使えるようにする機能です。目立つデザインのボタン、大きなフォントの文字などを使ってインターフェースを簡易化し、認識障害のある人がiPhoneやiPadの電話、メッセージ、カメラ、写真、ミュージックなどのアプリを簡単に使えるようにします。

ライブスピーチとパーソナルボイス

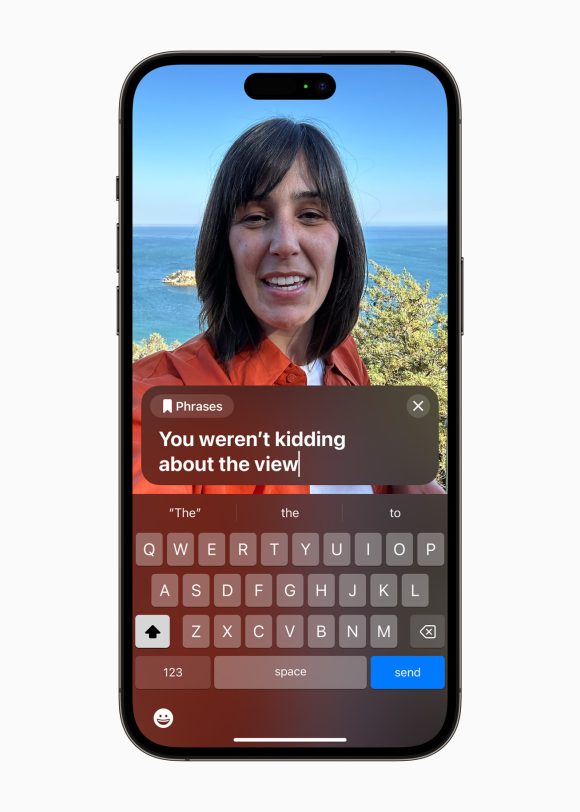

「ライブスピーチ」を使うと、iPhone、iPad、Macで入力した文字を、電話やFaceTimeの最中、または会話中に音声化することができます。音声を発することができない人でも、家族や友人と音声会話が可能になります。

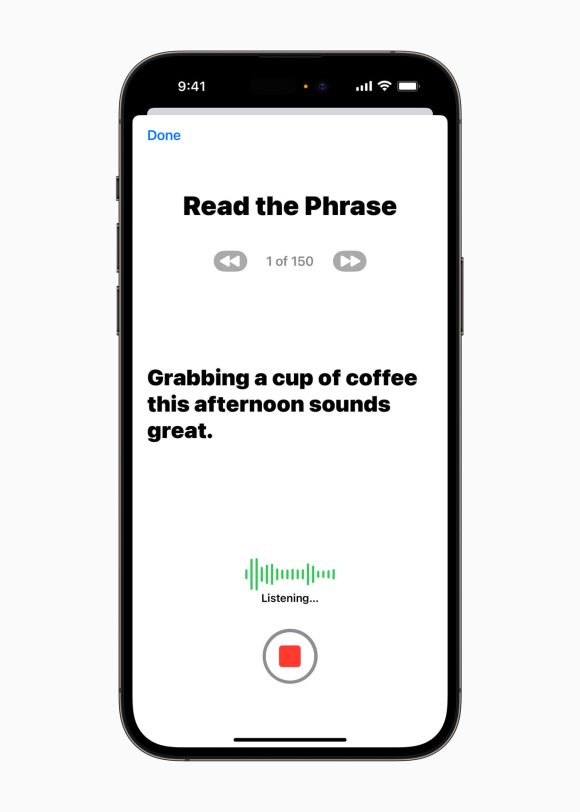

「パーソナルボイス」は筋萎縮性側索硬化症(ALS)などの疾患により、音声を失いつつあるユーザーが、自分の声と似た音声を作成できる機能です。

ユーザーはiPhoneやiPadでテキストを読み上げ、15分程度の音声を録音してパーソナルボイスを作成します。パーソナルボイスとライブスピーチとの統合により、ユーザーは自分の声で、家族や友人とずっと音声会話を継続することができます。

ただしパーソナルボイスは、当面は英語のみの対応となります。

拡大鏡アプリの「ポイント・アンド・スピーク」

拡大鏡アプリに追加される「ポイント・アンド・スピーク」機能は、視覚障害のあるユーザーが、物体に貼られた複数の異なるラベルを読む時に役立ちます。仮に新しい電子レンジを初めて使うとしましょう。カメラアプリとLiDARスキャナで読み取った画像上で拡大鏡の「ポイント・アンド・スピーク」を使うと、ユーザーの指の動き通りにテキストが読み上げられます。

つまり指が画像のボタンにふれると、そのボタンに書かれた文字が読み上げられるというわけです。

ポイント・アンド・スピークは、日本語にも対応します。

Appleはこのほかにも複数の新しいアクセシビリティ機能を導入する計画とのことです。

Source:Apple

(lunatic)

- Original:https://iphone-mania.jp/news-537268/

- Source:iPhone Mania

- Author:iPhone Mania

Amazonベストセラー

Now loading...