近年は自動運転技術が急速に発展しており、自家用車をはじめタクシー、バス、トラックにおける自動運転技術の実証実験が国内外で行われている。

実用化に向けた取り組みが加速する一方で、「ルールベースのプログラミングへの依存度が高い」「一般化が不十分」「コストが高い」「パフォーマンスが固定されている」などの課題が浮上。自動運転の広範な採用と規模拡大は制限されている現状だ。

そんななか、自動運転を専門とするAI企業Nullmaxは、新たな自動運転技術「Nullmax Intelligence(以下、NIシステム)」を発表した。

同技術は、環境条件に反応する生物学的本能を持ちながら、画像、音声、テキストなどのさまざまな入力を人間の認知と同様に処理することが可能。その結果より高いレベルの安全性、知性、柔軟性を実現している。

障害物検出と3D再構築を実行、マップなしで操作可能

Nullmaxは2016年にシリコンバレーで設立された、自動運転に特化した企業。ビジョンベースの自動運転を専門とし、OEMやティア1のサプライヤー向けに包括的なインテリジェント運転ソリューションを提供している。2023年にはシリーズBラウンドで1億ドル以上を獲得し、製品強化に努めている。

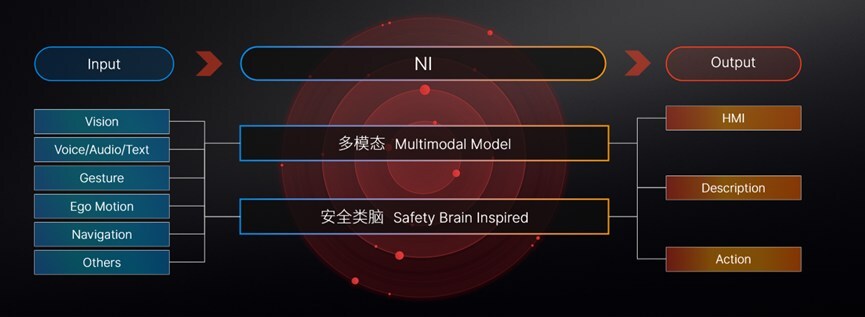

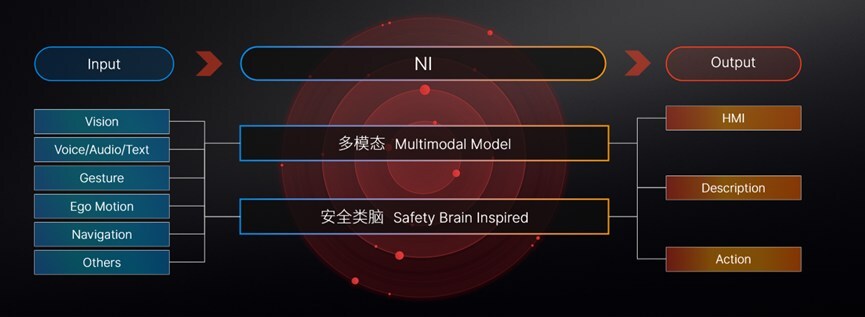

そんなNullmaxが今回発表したNIシステムは、マルチモーダルモデルと脳からヒントを得た安全モデルを搭載し、車両に視覚、聴覚、読解に似た感覚機能を付与するというもの。

そんなNullmaxが今回発表したNIシステムは、マルチモーダルモデルと脳からヒントを得た安全モデルを搭載し、車両に視覚、聴覚、読解に似た感覚機能を付与するというもの。

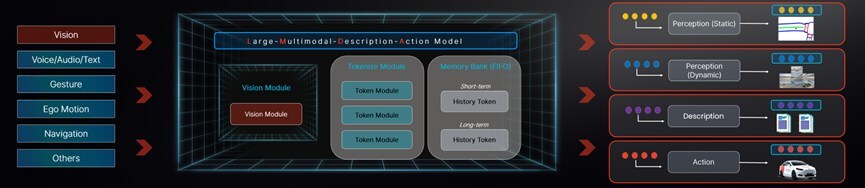

NIシステムではLiDARやステレオカメラに頼ることなく、視覚認識を使用して正確な障害物検出と3D再構築を実行し、ナビゲーション用のリアルタイムのローカルマップを生成する。

一般的な都市ナビゲーションはLiDARやHDマップ情報に大きく依存しており、柔軟性に欠ける動作を見せることが多く、特定の地域や道路への適用が制限されるが、NIシステムならそういった心配はない。

音声、テキスト、ジェスチャー情報の統合を支援

NIシステムは視覚入力だけでなく、エンドツーエンドのマルチモーダルモデル推論を通じて音声、テキスト、ジェスチャー情報の統合をサポート。視覚認識の結果、シーンの説明、運転行動などのさまざまな情報を出力する。

NIシステムは視覚入力だけでなく、エンドツーエンドのマルチモーダルモデル推論を通じて音声、テキスト、ジェスチャー情報の統合をサポート。視覚認識の結果、シーンの説明、運転行動などのさまざまな情報を出力する。

こうした包括的な機能により、フルシナリオのアプリケーションがサポートされ、必要な計算能力が少なくなる。フルシナリオの運転条件は、100T未満の計算能力で十分だという。

NIシステムによって、Nullmaxは2025年までにフルシナリオの自動運転を実現し、AI機能を乗客輸送、貨物配送、ロボット工学などの分野に拡張し、視覚的観察と認知的思考を通じて物理世界との相互作用の実現を目指す。

参考・引用元:

Nullmax

PR Newswire

(文・Haruka Isobe)

- Original:https://techable.jp/archives/241516

- Source:Techable(テッカブル) -海外テックニュースメディア

- Author:Haruka Isobe

Amazonベストセラー

Now loading...